A&I

AI为什么胡言乱语?

摘要

随着信息技术的迅猛发展,信息抓取与处理在各类应用场景中扮演着至关重要的角色。本文是从《Attention is All You Need》该论文得到灵感,试图去理解 GPT 是如何实现文本分析(因为 GPT 牛头不对马嘴的回复)。基于 Transformer 架构的生成式预训练模型 GPT,在信息抓取能力方面展现出卓越的性能。本文旨在系统调研 GPT 模型的信息抓取能力,深入解析其核心架构——Transformer 在实现高效信息提取与整合中的关键作用。首先,本文先调研了 LLM,先从根本分析了大语言模型的基本架构,然后我们在具体从 GPT 的角度分析了 GPT 在基本的 Transform模型中进行了什么样的改动,从中分析 GPT 的语言分析存在的特殊能力和不足。此外,本文评估了 GPT 模型在实际信息抓取任务中的应用效果以及分析其信息抓取目前存在的不足,包括数据挖掘、知识图谱构建及实时信息更新等,希望能在 GPT 的训练结构和 GPT 的发展历程找到解决 GPT 分析文本中存在的问题。

关键词:GPT 模型,Transformer 架构,信息抓取,自注意力机制,NLP

相关研究

第一部分: LLM 的文本分析能力:

图表 1(GPT 的架构)

在研究 GPT 的信息抓取能力时,理解其作为大型语言模型(LLM)的基础十分关键。GPT 是一种基于深度学习的 LLM,通过预训练和微调两个主要阶段来实现其强大的文本分析能力.微调是通过一些人为的问答形式,一些高质量的文本输入从而更为精准的将 GPT 训练成更为符合人类需求的产品,本文主要是研究 GPT 的信息抓取,所以我们是主要研究它的‘P’(预训练),以下将主要分析 GPT 的预训练过程和 GPT 进行信息抓取及文本生成存在的一些问题。

预训练阶段是 LLM 的核心环节。在这一阶段,模型会在海量的文本数据上进行训练,学习语言的基本结构、语法规则以及丰富的语义关系。通过处理来自书籍、文章、网页等多种来源的数据,GPT 积累了大量的语言知识,使其能够理解和生成

自然语言文本。这种大规模的预训练不仅帮助模型掌握词汇和句法,还使其能够捕 捉到语言中的细微差别和复杂关系。在实际应用中,当 GPT 接收到输入数据时,它并不是仅仅处理单个的文本片段,而是结合上下文进行分析,这意味着模型会考虑输入文本与其之前和之后的内容之间的关系,从而更准确地理解文本的整体含义。 GPT 通过自注意力机制(Self-Attention Mechanism)来识别和关联输入文本中的不同部分,使其能够处理长距离依赖关系,理解复杂的句子结构,并识别隐含的语义信息。此外,LLM 的性能在很大程度上依赖于其庞大的参数数量。参数量的增加意味着模型内部存储的知识和模式更多,能够更细致地捕捉语言中的各种细节。这种庞大的参数规模使得 GPT 在处理复杂的语言任务时表现得更加敏锐和高效,能够生成更为准确和流畅的文本。参数越多,模型的表达能力和问题解决能力也就越强,这对于理解和生成自然语言至关重要。

总而言之,GPT 的信息抓取能力与其训练的数据的规模息息相关,数据规模越 大,能让 GPT 更能准确的分析文本的核心含义,也能更优秀的生成合理正确的答案。数据量的足够巨大,GPT 的参数量也会变得巨大,而 GPT 的参数量就相当于 GPT 过程中学到的知识,也相当于它的知识储备,从而它能更为细致入微的捕捉到语言的细节,回答的语句也会更加精确。

图表 2(token 的选择)

但是在研究 GPT 的信息抓取的过程中我们也能清晰的看到它的弊端,就是它生成的语句是根据“可能性来回答的”,简而言之,就是它回答一句话的过程,是它认为概率最大的句子,它会根据你给的内容,它对这个词的下一个词进行可能性分析,然后选取其中概率性最大的词,就如同我们的输入法,百度搜索一样,他会判断你下一个词语的可能性。然而这样的生成有时候是不如人意的,这就是为什么我们时常会说“GPT 是不是生病了”,然而这个能不能有更好的解决办法呢?我们请往下看,直到分析问 GPT 的信息抓取的历程,我们或许会从中找到答案。

第二部分:大语言模型文本分析的发展史

迭代过程 : RNN –> LSTM –> Transformer

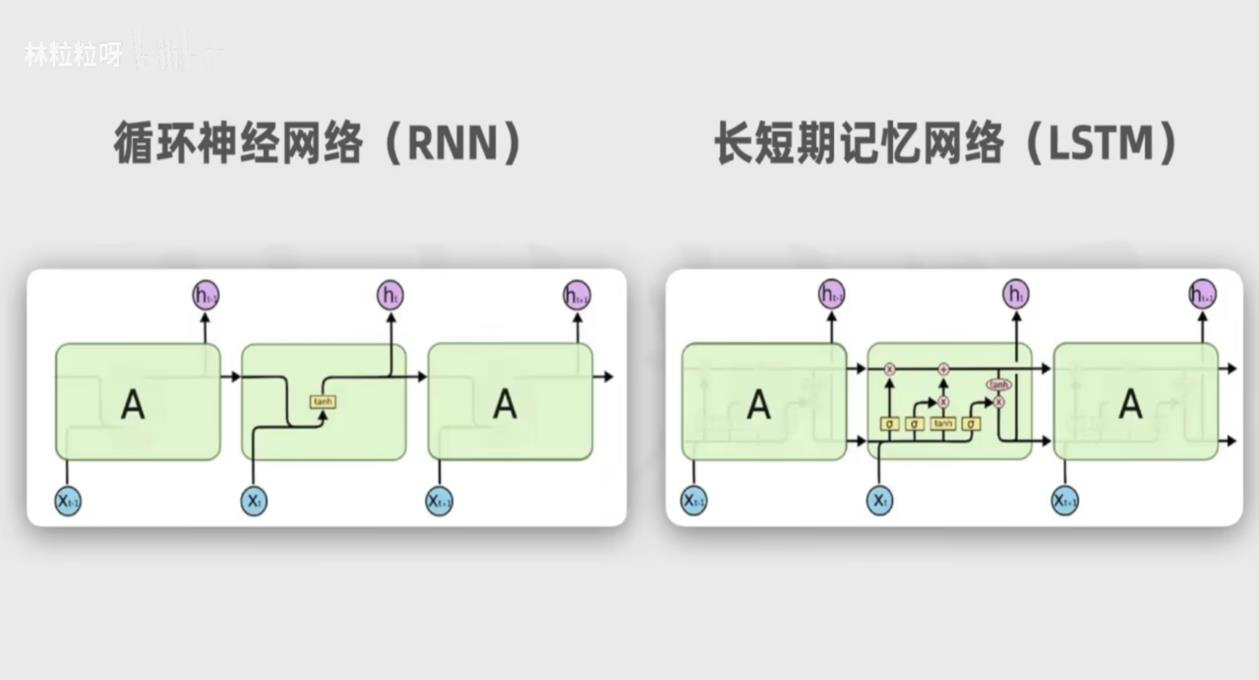

图表 3

在讨论 Transform 的结构之前,了解其背后的发展历程至关重要。最初,循环神经网络(Recurrent Neural Network, RNN)被广泛应用于自然语言处理任务,因为其能够处理序列数据并捕捉时间上的依赖关系。然而,RNN 在处理长距离依赖时常常遇到梯度消失或爆炸的问题,限制了其性能的提升。为了解决这些问题,长短期记忆网络(Long Short-Term Memory, LSTM)被提出。

LSTM 通过引入门控机制,有效地缓解了 RNN 的缺陷,能够更好地捕捉和记忆长距离依赖关系,从而在诸多语言任务中取得了显著进展。然而,尽管 LSTM 在一定程度上改善了 RNN 的局限性,但其序列化的计算方式仍然限制了模型的训练效率和扩展性。2017 年,Vaswani 等人在论文《Attention is All You Need》中提出了 Transformer 模型,彻底改变了自然语言处理的研究方向。Transformer 摒弃了传统的递归结构,采用自注意力机制(Self-Attention Mechanism)来并行处理整个序列,显著提升了计算效率和模型性能。自注意力机制使得模型能够在处理每个词汇时,动态地关注序列中所有其他位置的相关信息,从而更精准地捕捉上下文关系。Transformer 的引入不仅解决了 RNN 和 LSTM 在处理长距离依赖时的不足,还为后续的大规模语言模型如 GPT 奠定了坚实的基础。

通过这一迭代过程,从 RNN 到 LSTM 再到 Transformer,自然语言处理技术不断演进,逐步实现了更高效、更准确的信息抓取和文本分析能力。这一发展历程展示了深度学习在自然语言理解领域中的持续创新和突破,为 GPT 等先进模型的诞生提供了必要的理论支持和技术保障。

第三部分:Transformer 架构

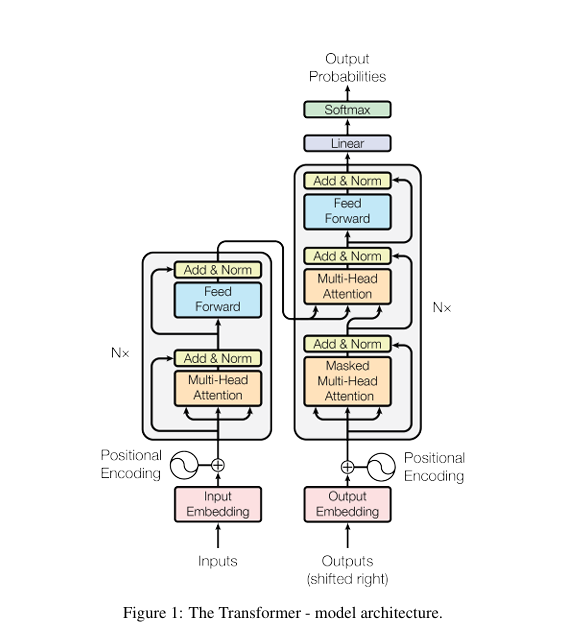

Transformer 架构通过多头自注意力和并行化处理突破了传统序列模型的局限, Transformer 是一个巨大而伟大的创新,从大语言模型的发展史来看, Transformer 还未出世的时候,大语言模型由于耗费计算过于巨大,浪费时间过长 而一度被人遗忘。但是由于这个伟大的革新让黯淡的 AI 散发出了耀眼的光芒。

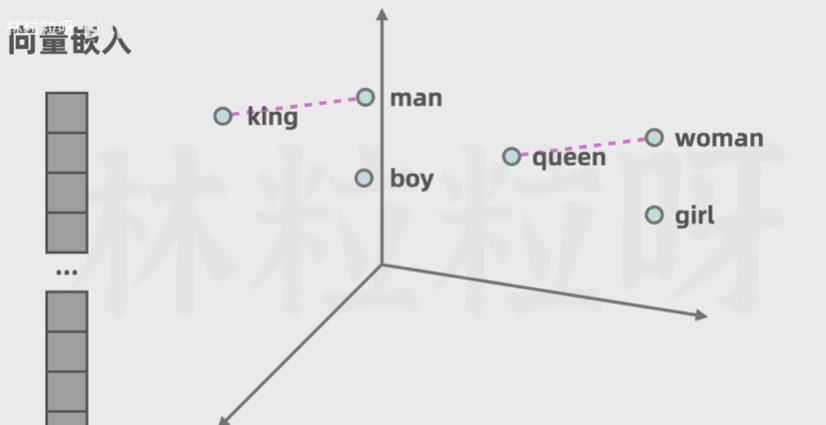

在 Transformer 的基本架构中,文本的处理过程可以被理解为从原始的字符或词汇一步步转化为模型能够理解的向量表示。首先,输入的文本会被拆分为较小的单位——称为“Token”(通常是词或词片段),每个 Token 都会用一个整数进行表示。随后,这些整数会被映射到一个称为“嵌入向量”的连续数值空间中。在这个空间中,相似含义的词所对应的向量更接近,从而为模型提供了表示词语语义关系的基础。在分析这里的时候有一个我感觉很有意思的地方就是,向量化以后在线性空间中,含义越相近的词语在向量空间中的距离更近,不得不说,能变成向量空间来处理的也是个天才!

图表 4(Word Embedding)

Transformer 在处理这些嵌入向量时,会通过“多头自注意力机制”来分析序 列中各个词与其他词之间的关联程度。与传统的序列模型(如 RNN 或 LSTM)逐字逐句处理的方式不同,Transformer 能在同一时间内并行地关注到序列中所有的词。为了让模型了解句子中词语的先后顺序,Transformer 还为每个 Token 添加了位置编码(Positional Encoding),这样即便是并行处理,模型依然能够知道每个词在整句话中所处的位置。

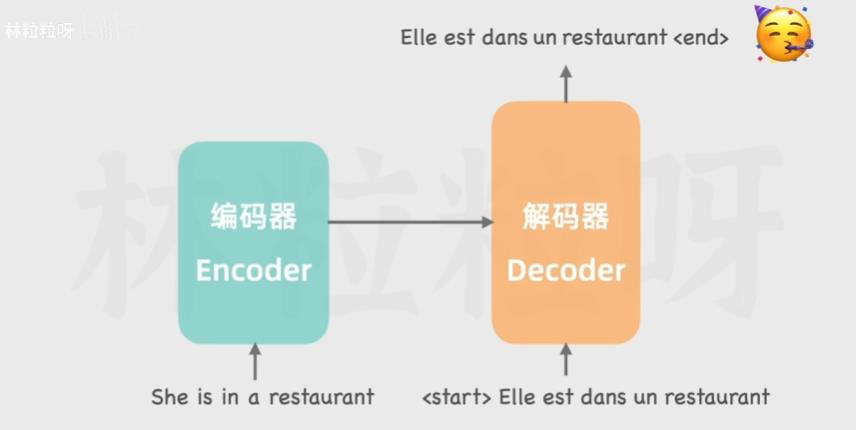

基于 Transformer 这一框架,GPT(Generative Pre-trained Transformer)对模型结构进行了简化和改进。与完全使用编码器-解码器结构的 Transformer 不同,GPT 主要使用了 Transformer 的解码器部分来构建语言模型。具体来说,GPT在训练时采用了海量的未标注文本数据进行预训练,让模型在无指导的情况下学习

词与词之间的统计和语义关系。由于 GPT 专注于单向预测(从左到右依次预测下一个词),其计算流程相对简单,但通过参数量和数据规模的显著扩大,模型在理解上下文和生成自然文本方面表现出了优异的能力。预训练结束后,GPT 可以通过少量样本的微调或直接使用其学到的知识来完成多种自然语言处理任务。

图表 5(内容处理)

总而言之,Transformer 通过并行注意力机制和向量化的词语表示,让模型能够高效理解文本的内部结构。基于此,GPT 将 Transformer 的思想应用于大规模预训练策略,使模型在无需手动标注的情况下,充分学习语言的潜在规律,从而在文本生成与理解上达到更高的水准。

图表 6(transformer 架构)

总结

相关的内容也到此结束了,现在来解决一开始提出的问题,遇到 GPT 的“已读乱回”我们到底能不能找到一个很好的解决办法,经过具体实验分析,我认为它的已读乱回跟它的缓存有关,有时候给他识别一个图片,它无法分析到这个图片的时候,它会将它缓存中的图片来进行分析,这就也可能会导致,你问它的问题它识别不了,它会给你回答它缓存中你问它的问题。我感觉这个就是 GPT 本身可能缓存方面就存在一些问题。还有就是它对于一个物理数学等问题的回答简直是牛头不对马嘴的情况,这个根据上面相关研究的内容我们可以清晰的知道,GPT 的语言理解能力和它的分析能力是与它的预训练息息相关的,自然,这个问题也要从他的预处理部分来解决,这个和他的 Tranformer 的机制相关,他会预测频率最高的词语来作为回答,所以我认为解决的办法有两种,第一个就是加大这个误答方面的知识的数据训练,第二就是加大其微调的知识面。但是 GPT 是为广大群众服务的,需要更为专业的 AI 还是要自己训练可能回答会更为精准。

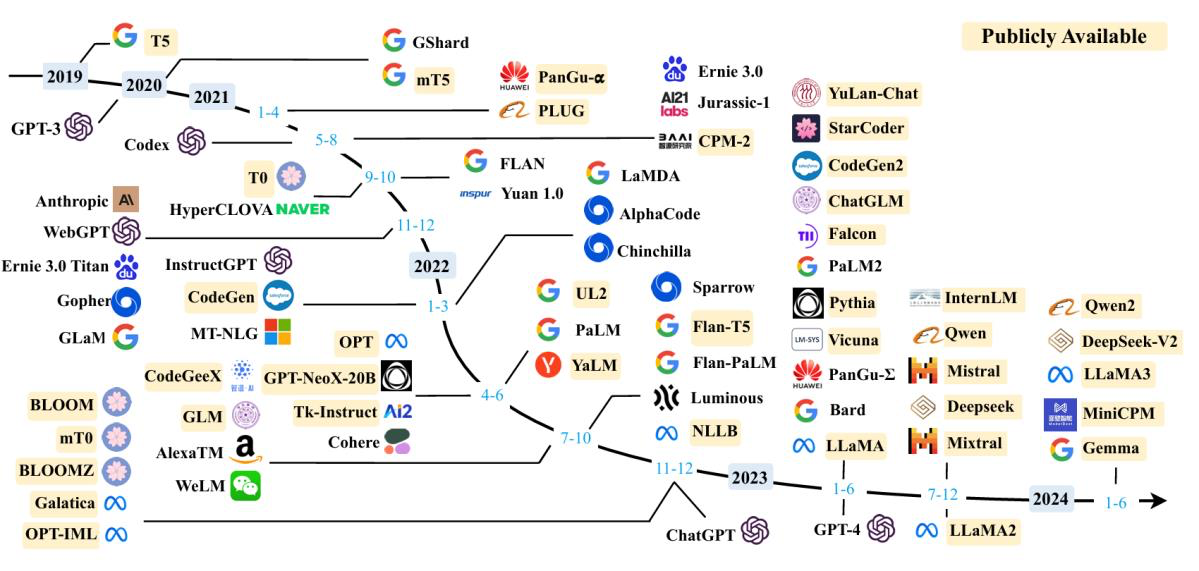

图表 7(大语言模型的 Development)

在调研完 GPT 的信息抓取能力后,大概也对 GPT 的信息分析能力有了一个初步认知,我有一个很深的感悟便是 LLM 的发展往往不是这么容易的,从一开始的无人问津到现在的时代新星,每一步都凝聚着广大 AI 工作者的汗水,例如 GPT 它的发展,千亿级别的参数量,不知是多少工作者进行的微调,不知道是多少个日日夜夜的努力才能实现如今这个如此伟大的 GPT,致敬每一个为 AI 辛勤工作的人,也祝愿人工智能在越来越好。